서론

AI 이야기를 듣다 보면 비슷해 보이는 단어들이 많이 보인다. 딥러닝, LLM, 자연어 처리 등 이런 유사해 보이는 단어들을 정의하고, 내부 구현을 살펴보기보다는 기본적인 개념에 대해 정리해보려고 한다. 내용은 LLM을 활용한 실전 AI 애플리케이션 개발을 많이 참고하였다.

요즘 누구나 ChatGPT나 Gemini를 일상 속에서 쉽게 활용하고는 한다. ChatGPT와 Gemini는 LLM을 활용한 서비스인데, 대체 어떤 원리로 답변을 만들어내는 걸까? 굉장히 단순하다. 주어진 입력에서 다음에 올 적절한 단어를 확률적으로 선택하고, 문장이 끝날 때까지 이 '적절한 단어를 확률적으로 선택'하는 과정을 반복한다. 이런 식으로 다음에 올 단어를 예측하는 모델을 언어 모델이라 부르기도 하고, 사람과 비슷한 말을 만든다 하여 자연어를 생성한다고 표현하는 등 다양한 이야기가 있는데 아래에서 차근차근 정리해 보자.

딥러닝부터 LLM까지

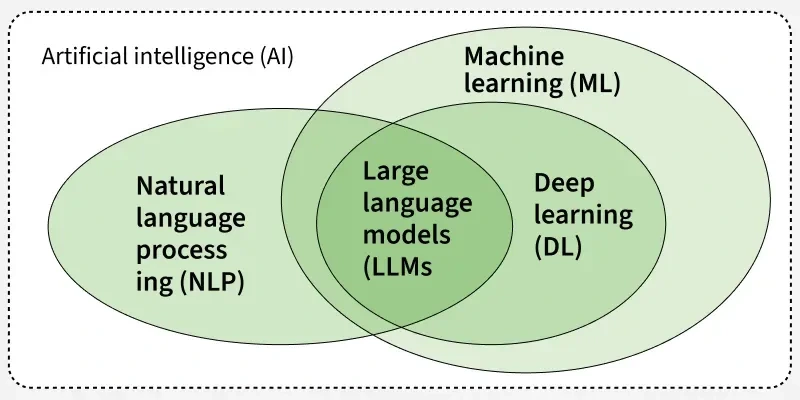

LLM에 대해 살펴보기 전, 자주 등장하는 용어들을 간단히 살펴보자.

- 인공지능; AI; Artificial Intelligence

- 학습, 추론, 문제 해결과 같이 일반적으로 인간의 지능이 필요한 문제를 컴퓨터가 해결할 수 있게 만드는 기술

- 딥러닝; Deep Learning

- 인간의 두뇌에 영감을 받아 만들어진 신경망

- 데이터의 패턴을 학습하는 머신러닝(machine learning, 기계 학습)의 한 분야

- 자연어 처리; Natural Language Processing

- 사람의 언어를 컴퓨터가 이해하고 생성할 수 있도록 하는 연구

- 사람과 비슷한 텍스트를 생성하는 것은 자연어 생성(Natural Language Generation)이라고도 함

LLM은 딥러닝과 자연어 생성의 교집합으로, 딥러닝 기반의 언어 모델로 표현되기도 한다.

머신러닝과 딥러닝

앞에서 딥러닝은 데이터의 패턴을 학습하는 머신 러닝의 한 분야라고 정의하였다. 그렇다면 머신 러닝이 무엇일까? 머신 러닝은 명시적인 지시를 사람이 직접 작성하지 않아도 데이터 분석 작업을 수행하는 인공지능의 한 유형이다. 대량의 데이터를 처리하고, 패턴을 분석하고 식별하여 데이터 간의 새로운 관계를 예측할 수 있다.

예전에 머신 러닝은 데이터가 있으면 사람이 먼저 데이터에 대한 특징을 정의하여 모델에 입력을 넣었다. 예를 들어 자동차라는 데이터는 바퀴가 있다, 문이 달려 있다, 창문이 있다 등의 특징을 뽑아냈다. 여기서 딥러닝의 특별한 점은, 모델이 스스로 데이터의 특징을 찾고 분류하는 모든 과정을 학습한다는 점이다.

언어 모델과 학습 방식

언어 모델

LLM은 딥러닝 기반의 언어 모델이라고 표현되기도 한다. 여기서 언어 모델이란, 이전 단어들이 주어졌을 때 다음 단어가 무엇 일지를 예측하도록 학습된 모델을 말한다. 예를 들어 다음과 같은 문장이 있을 때,

오늘 날씨가 너무

=> 춥다 / 덥다 / 좋다다음에 올 단어가 무엇일지 확률적으로 예측하는 것이 언어 모델의 역할이다.

이처럼 다음 단어를 예측하는 방식으로 모델을 학습시키는 과정을 언어 모델링(language modeling)이라고 한다. 언어 모델링은 단순히 텍스트를 생성하기 위한 기술로만 쓰이지 않는다. 대량의 텍스트 데이터를 이용해 문법, 문맥, 단어 간 관계 같은 언어의 일반적인 특성을 학습하는 데에도 매우 적합하다.

전이 학습

기존의 머신러닝 모델 학습은 처음부터 끝까지 해결하려는 문제에 대한 데이터로만 학습했다. 하지만 딥러닝 모델 학습에서는 하나의 문제를 해결하는 과정에서 얻은 지식과 정보를 다른 문제를 풀 때도 재사용하는 방식인 전이 학습(transfer learning)을 많이 활용한다.

전이학습의 단계

- 사전 학습(pre-training): 대량의 데이터로 모델을 학습

- 미세 조정(fine tuning): 특정 문제를 해결하기 위한 데이터로 추가 학습

사전 학습에서 중요한 것은 무슨 문제(task)를 풀도록 학습시킬까?이다. 자연어 처리 분야에서는 이 질문에 대한 답으로 주목받은 것이 바로 언어 모델링이다. 이와 관련하여 몇 가지 논문과 연구가 있는데 이 글에서는 자세한 내용을 생략한다.

임베딩

컴퓨터는 숫자만 처리할 수 있다. 딥러닝 모델은 데이터의 의미를 숫자의 집합으로 표현하는데 이를 임베딩(embedding)이라고 한다. 이 임베딩 값은 숫자의 집합으로 이루어져 있기 때문에 두 임베딩 값에 대한 거리를 계산할 수 있다. 이 거리가 가까울수록 의미가 비슷하다고 판단하며, 이를 여러 작업에 활용할 수 있다.

- 검색 및 추천: 검색어와 관련이 있는 상품 추천

- 클러스터링 및 분류: 유사하고 관련이 있는 데이터 하나로 묶기

- 이상치(outlier) 탐지: 나머지 데이터와 거리가 먼 데이터를 이상치로 분류

LLM 모델의 아키텍쳐

딥러닝이나 머신 러닝에서의 텍스트는 단어가 연결된 문장 형태의 데이터를 말한다. 이처럼 작은 단위(단어)가 연결되고, 그 길이가 다양한 데이터의 형태를 '시퀀스(sequence)'라고 한다. 이런 시퀀스 데이터 처리를 위한 다양한 모델이 있는데, 이 모델의 아키텍쳐로 유명한 게 RNN과 트랜스포머 아키텍처다.

RNN의 연산 방식

- 입력하는 텍스트를 순차적으로 처리하여 다음 단어를 예측

- 하나의 잠재 상태(hidden state)에 지금까지의 입력 텍스트에 대한 맥락을 압축

- 잠재 상태에 대한 압축이 거듭되며 내용이 길어질수록 먼저 입력된 단어들에 대한 의미가 희석됨

트랜스포머 아키텍쳐의 연산 방식 (=어텐션 연산)

- 맥락 데이터를 모두 활용해 다음 단어를 예측

- 입력 텍스트가 길어지면

- 메모리 사용량 증가 (맥락 데이터를 모두 저장하고 있어야 하기 때문에)

- 예측에 걸리는 시간 증가

이렇게 어텐션 연산을 통해 트랜스포머 아키텍처는 RNN에서 발생 가능한 다양한 문제를 해결할 수 있어, 지금도 많은 모델에서 사용된다. 이번에는 간단한 소개로만 그치고, 이후에 별도 포스트로 트랜스포머 아키텍쳐에 대한 자세한 동작을 정리하겠다.

LLM의 발전과 다양한 기술

기존의 자연어 처리에서는 복합적인 작업을 수행하기 위해 언어 이해 모델과 언어 생성 모델을 각각 개발해 연결했는데 많은 모델을 개발하고 연결할수록 시스템의 복잡도가 높아지고 관리도 어려워졌다. 하지만 이제는 현대 기술의 발전으로 모델의 크기가 커지면서 LLM의 언어 추론 능력과 언어 이해 능력이 크게 높아졌다. 하나의 LLM으로 다양한 작업에 AI를 활용할 수 있게 된 것이다.

LLM을 더욱 잘 활용할 수 있기 위해 다양한 기술들이 등장하였는데 이번 챕터에서는 그런 기술들에 대해 간단히 살펴보고자 한다.

sLLM; Small Large Language Model

- LLM 대비 크기를 경량화한 모델

- 추가 학습이 필요할 때 특정 도메인 데이터/작업에서 높은 성능을 보이는 작은 규모의 모델을 만들기도 함

GPU

- GPU: 많은 연산을 병렬로 처리하는 데 특화된 처리 장치

- 모델 성능을 높이기 위해 모델 크기를 늘리며, LLM의 학습과 추론에 필요한 연산량도 크게 증가

- 많은 연산양을 빠르게 처리하기 위해 GPU 사용

- 더 효율적인 GPU 사용을 위해 다양한 연구 진행

- 양자화(quantization): 모델 파라미터를 더 적은 비트로 표현

- LoRA(Low Rank Adaption): 모델 전체가 아닌 일부만 학습

- 어텐션 연산 개선

RAG; Retrieval Argument Generation

- 할루시네이션 현상 완화 (할루시네이션: 잘못된 정보나 실존하지 않는 정보를 답변하는 현상)

- 자세한 내용은 별도 포스트 - RAG란? 에 정리

RAG란?

지난번 LangChain이란? 포스팅에서 RAG를 아래와 같이 설명했다. 1. RAG= Retrieval Augmented Generation, 검색 증강 생성외부 데이터를 참조하여 LLM의 정확도와 신뢰성 향상에 도움을 주는 기술 그런데 왜 외

yeonyeon.tistory.com

참고

- LLM을 활용한 실전 AI 애플리케이션 개발 / 허정준

- AWS - What is Machine Learning?

- Baeldung - What Does Pre-training a Neural Network Mean?

'Develop > AI' 카테고리의 다른 글

| RAG란? (0) | 2025.11.04 |

|---|---|

| LangChain이란? (2) | 2025.11.03 |